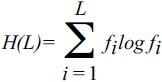

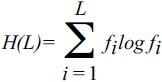

Здесь fi — частота символа i (i = A, T, G, C); далее, основание логарифма m считается равным размеру алфавита (4 в случае нуклеотидных последовательностей и 20 для аминокислотных последовательностей)

[71]. Определенная таким образом, информация (энтропия) говорит нам очень мало об осмысленном информационном содержании или сложности геномной последовательности. Высокая сложность (энтропия или информационное содержание), очевидно, вовсе не предполагает, что последовательность сложна в каком-либо биологическом значимом смысле. Совершенно случайная последовательность на самом деле, скорее всего, бессмысленна, в то время как гомополимерная последовательность будет иметь ограниченный биологический смысл. Тем не менее почти случайная высокоэнтропийная последовательность может быть столь же функциональной, как и низкоэнтропийная последовательность, — способа узнать это просто не существует. Требуется биологически содержательное определение сложности, и такая попытка была сделана Крисом Адами (Adami, 2002) и несколько по-другому проинтерпретирована автором этой книги (Koonin, 2004). В соответствии с этим новым определением, энтропия и сложность рассчитываются для выравнивания ортологичных последовательностей, а не одной последовательности:

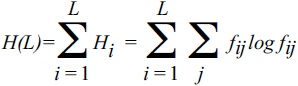

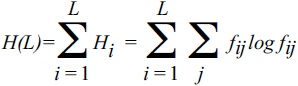

Здесь H(L) — полная энтропия выравнивания n последовательностей длины L, Hi — энтропия для сайта, а Fij — частоты для нуклеотидов (j = A, T, G, C) в сайте i

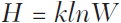

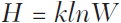

[72]. Очевидно, для полностью консервативного сайта H(i) = 0, в то время как для совершенно случайного сайта H(i) = 1. Обратите внимание, что это определение энтропии полностью соответствует знаменитому статистическому определению Больцмана:

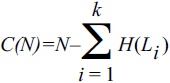

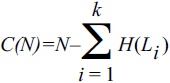

Здесь W — число микросостояний, соответствующих макросостоянию, для которого энтропия рассчитывается таким образом, что она равна нулю для полностью упорядоченного состояния и максимальна для полностью неупорядоченного состояния. Таким образом, определение эволюционной энтропии генома H(L), введенной предыдущей формулой, представляется физически корректным, следовательно, имеет смысл закрепить термин за обозначением этой величины. Эволюционная энтропия также имеет четкий биологический смысл: сайты с низкой энтропией сохраняются лучше и, как следствие, более важны функционально. Логично, что эти сайты несут больше информации о функционировании и эволюции рассматриваемых организмов — и о взаимодействиях между организмами и окружающей средой, что первоначально имел в виду Адами, — чем сайты с высокой энтропией (слабо сохраняемые, относительно неважные). Величина, которую можно определить как биологическую (эволюционную) сложность генома, определяется следующим образом:

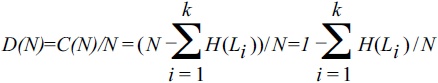

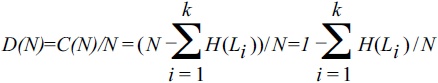

Тогда биологическая (эволюционная) плотность информации может быть задана как:

Здесь N — общая длина (число нуклеотидов) генома, Li — длина геномного сегмента, подверженного измеримому отбору (как правило, ген), k — число таких сегментов в геноме, H(L) — эволюционная энтропия для сегмента L, рассчитанная по предыдущей формуле.

Точные значения H нелегко вычислить для полных геномов, поскольку распределение эволюционных ограничений никогда не известно точно (см. гл. 3). Кроме того, есть степень произвольности в выборе ортологов, включаемых для расчета в выравнивание. Тем не менее эти детали не столь важны, если нам нужна только приблизительная оценка. Действительно, доля сайтов, находящихся под отбором по всему геному, уже оценена с достаточной точностью для некоторых модельных организмов, таких как человек и дрозофила (см. гл. 3). Для других, в частности прокариот и одноклеточных эукариот, в качестве достаточного приближения можно взять долю кодирующих нуклеотидов плюс предполагаемую долю регуляторных сайтов; для участков под отбором за среднее значение энтропии можно принять H(i) = 0,5.

Сравнение оценок для H(N), C(N) и D(N) для геномов различных жизненных форм выявляет фундаментальный парадокс. Общая биологическая сложность C(N) монотонно возрастает с размером генома, в частности, для многоклеточных эукариот по сравнению с прокариотами, однако энтропия H(N) возрастает гораздо быстрее, в результате эволюционная плотность информации D(N) резко падает (см. рис. 8-2). Таким образом получается, что организмы, которые обычно воспринимаются как наиболее сложные (к примеру, человек), обладают «энтропийными» геномами с низкой или даже крайне низкой плотностью информации, в то время как организмы, которые мы традиционно считаем примитивными, такие как бактерии, обладают «информационными» геномами, в которых информация плотно упакована и плотность ее высока. Этот парадокс не даст нам много нового по сравнению с уже сказанным в главе 3 об организации различных геномов. Тем не менее поучительно формализовать понятие биологической сложности и выразить его в терминах энтропии, одного из ключевых понятий физики. Формальный разбор понятия сложности указывает на то, что «неладно что-то в Датском королевстве»: геномы организмов, которых мы вполне обоснованно считаем самыми сложными и наиболее «развитыми» (эта идея, возможно, менее оправдана), несут гораздо больше энтропии и, следовательно, имеют гораздо меньшую плотность биологической информации, чем геномы простейших клеточных форм. Перефразируя этот парадокс в более провокационной форме, геномы одноклеточных организмов (особенно прокариот) кажутся несравненно «лучше спроектированными», чем геномы растений и особенно животных.