Прежде чем глубже погрузиться в метод обучения ценностям, было бы полезно проиллюстрировать идею на примере. Возьмем лист бумаги, напишем на нем определение какого-то набора ценностей, положим в конверт и заклеим его. После чего создадим агента, обладающего общим интеллектом человеческого уровня, и зададим ему следующую конечную цель: «Максимизировать реализацию ценностей, описание которых находится в этом конверте». Что будет делать агент?

Он не знает, что содержится в конверте. Но может выстраивать гипотезы и присваивать им вероятности, основываясь на всей имеющейся у него информации и доступных эмпирических данных. Например, анализируя другие тексты, написанные человеком, или наблюдая за человеческим поведением и отмечая какие-то закономерности. Это позволит ему выдвигать догадки. Не нужно иметь диплом философа, чтобы предположить, что, скорее всего, речь идет о заданиях, связанных с определенными ценностями: «минимизируй несправедливость и бессмысленные страдания» или «максимизируй доход акционеров», вряд ли его попросят «покрыть поверхность всех озер пластиковыми пакетами».

Приняв решение, агент начинает действовать так, чтобы реализовать ценности, которые, по его мнению, с наибольшей вероятностью содержатся в конверте. Важно, что при этом он будет считать важной инструментальной целью как можно больше узнать о содержимом конверта. Причина в том, что агент мог бы лучше реализовать почти любую конечную ценность, содержащуюся в конверте, если бы знал ее точную формулировку — тогда он действовал бы гораздо эффективнее. Агент также обнаружит конвергентные инструментальные причины (описанные в главе седьмой): неизменность целей, улучшение когнитивных способностей, приобретение ресурсов и так далее. И при этом, если исходить из предположения, что он присвоит достаточно высокую вероятность тому, что находящиеся в конверте ценности включают благополучие людей, он не станет стремиться реализовать эти инструментальные цели за счет немедленного превращения планеты в компьютрониум, тем самым уничтожив человеческий вид, поскольку это будет означать риск окончательно лишиться возможности достичь конечной ценности.

Такого агента можно сравнить с баржей, которую несколько буксиров тянут в разные стороны. Каждый буксир символизирует какую-то гипотезу о конечной ценности. Мощность двигателя буксира соответствует вероятности гипотезы, поэтому любые новые свидетельства меняют направление движения баржи. Результирующая сила перемещает баржу по траектории, обеспечивающей обучение (неявно заданной) конечной ценности и позволяющей обойти мели необратимых ошибок; а позднее, когда баржа достигнет открытого моря, то есть более точного знания конечной ценности, буксир с самым мощным двигателем потянет ее по самому прямому или благоприятному маршруту.

Метафоры с конвертом и баржей иллюстрируют принцип, лежащий в основе метода обучения ценностям, но обходят стороной множество критически важных технических моментов. Они станут заметнее, когда мы начнем описывать этот метод более формально (см. врезку 10).

Как можно наделить ИИ такой целью: «максимизируй реализацию ценностей, изложенных в записке, лежащей в запечатанном конверте»? (Или другими словами, как определить критерий цели — см. врезку 10.) Чтобы сделать это, необходимо определить место, где описаны ценности. В нашем примере это требует указания ссылки на текст в конверте. Хотя эта задача может показаться тривиальной, но и она не без подводных камней. Упомянем лишь один: критически важно, чтобы ссылка была не просто на некий внешний физический объект, но на объект по состоянию на определенное время. В противном случае ИИ может решить, что наилучший способ достичь своей цели — это заменить исходное описание ценности на такое, которое значительно упростит задачу (например, найти большее число для некоторого целого числа). Сделав это, ИИ сможет расслабиться и бить баклуши — хотя скорее за этим последует опасный отказ по причинам, которые мы обсуждали в главе восьмой. Итак, теперь встал вопрос, как определить это время. Мы могли бы указать на часы: «Время определяется движением стрелок этого устройства», — но это может не сработать, если ИИ предположит, что в состоянии манипулировать временем, управляя стрелками часов. И он будет прав, если определять «время» так, как это сделали мы. (В реальности все будет еще сложнее, поскольку соответствующие ценности не будут изложены в письменном виде. Скорее всего, ИИ придется выводить ценности из наблюдений за внешними структурами, содержащими соответствующую информацию, такими как человеческий разум.)

ВРЕЗКА 10. ФОРМАЛИЗАЦИЯ ОБУЧЕНИЯ ЦЕННОСТЯМ

Чтобы яснее понять метод, опишем его более формально. Читатели, которые не готовы погружаться в математические выкладки, могут этот раздел пропустить.

Предположим, что есть упрощенная структура, в которой агент взаимодействует со средой конечного числа моментов

[462]. В момент k агент выполняет действие yk, после чего получает ощущение xk. История взаимодействия агента со средой в течение жизни m описывается цепочкой y1x1y2x2…ymxm (которую мы представим в виде yx1:m или yx≤m). На каждом шаге агент выбирает действие на основании последовательности ощущений, полученных к этому моменту.

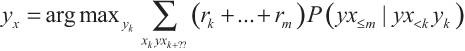

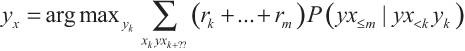

Рассмотрим вначале обучение с подкреплением. Оптимальный ИИ, обучающийся с подкреплением (ИИ-ОП), максимизирует будущую ожидаемую награду. Тогда выполняется уравнение

[463]

Последовательность подкреплений rk, …, rm вытекает из последовательности воспринимаемых состояний среды xk:m, поскольку награда, полученная агентом на каждом шаге, является частью восприятия, полученного на этом шаге.

Мы уже говорили, что такого рода обучение с подкреплением в нынешних условиях не подходит, поскольку агент с довольно высоким интеллектом поймет, что обеспечит себе максимальное вознаграждение, если сможет напрямую манипулировать сигналом системы наград (эффект самостимуляции). В случае слабых агентов это не будет проблемой, поскольку мы сможем физически предотвратить их манипуляции с каналом, по которому передаются вознаграждения. Мы можем также контролировать их среду, чтобы они получали вознаграждение только в том случае, если их действия согласуются с нашими ожиданиями. Но у любого агента, обучающегося с подкреплением, будут иметься серьезные стимулы избавиться от этой искусственной зависимости: когда его вознаграждения обусловлены нашими капризами и желаниями. То есть наши отношения с агентом, обучающимся с подкреплением, фундаментально антагонистичны. И если агент силен, это может быть опасно.