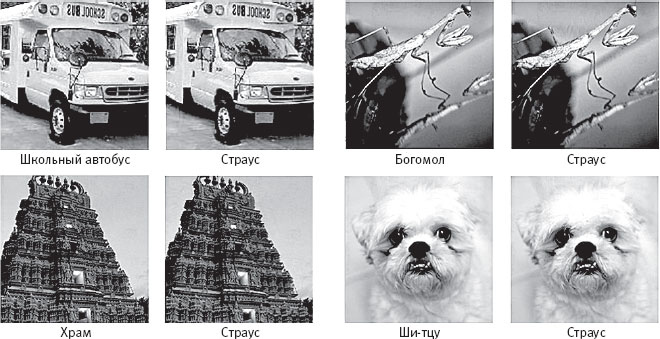

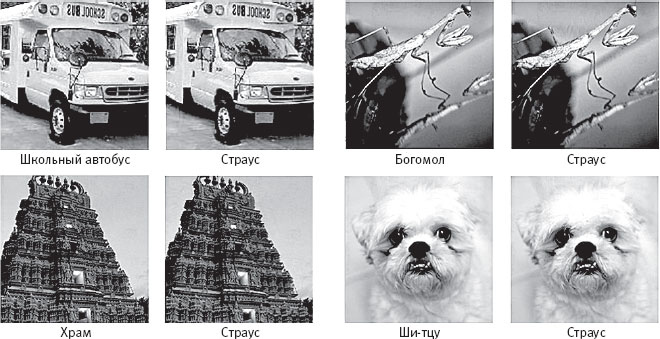

Рис. 18. Исходные изображения и контрпримеры для AlexNet. Слева в каждой паре представлено исходное изображение, корректно классифицированное AlexNet. Справа – контрпример, созданный на основе этого изображения (в пиксели изображения внесены небольшие изменения, но людям новое изображение кажется идентичным исходному). Каждый контрпример AlexNet уверенно отнесла к категории “страус”

В частности, авторы статьи обнаружили, что можно взять из ImageNet фотографию, которую AlexNet корректно классифицировала с высокой степенью уверенности (например, “школьный автобус”), и исказить ее путем внесения незначительных специфических изменений в пиксели таким образом, чтобы людям искаженная фотография казалась неизменной, а AlexNet с высокой уверенностью классифицировала ее в совершенно другую категорию (например, “страус”). Авторы назвали искаженное изображение “контрпримером”. На рис. 18 приводятся несколько исходных изображений и их контрпримеров. Не видите между ними разницы? Поздравляю! Похоже, вы человек.

Сегеди с соавторами создали компьютерную программу, которая брала из ImageNet любую фотографию, корректно классифицированную AlexNet, и вносила в нее специфические изменения, создавая новый контрпример, казавшийся неизменным людям, но заставлявший AlexNet с высочайшей уверенностью классифицировать фотографию неверно.

Что особенно важно, Сегеди с соавторами выяснили, что такая чувствительность к контрпримерам свойственна не только сети AlexNet: они показали, что несколько других СНС – с другой архитектурой, другими гиперпараметрами и тренировочными множествами – имеют сходные уязвимости. Назвать это “любопытным свойством” нейронных сетей – все равно что назвать пробоину в корпусе роскошного круизного лайнера “интересной особенностью” корабля. Да, все это очень любопытно и заслуживает дальнейшего исследования, но, если не залатать пробоину, корабль пойдет ко дну.

Вскоре после выхода статьи Сегеди с коллегами ученые Университета Вайоминга опубликовали статью с более однозначным названием “Глубокие нейронные сети легко обмануть”

[146]. Используя вдохновленный биологией вычислительный метод, называемый генетическими алгоритмами

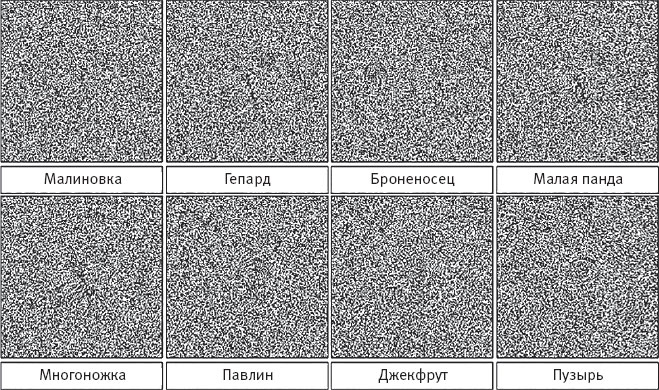

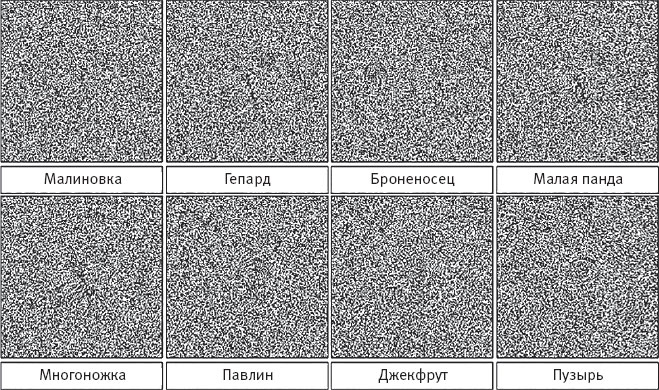

[147], ученые из Вайоминга смогли запустить вычислительный “эволюционный процесс” и получить в результате изображения, которые кажутся людям случайным шумом, но AlexNet классифицирует их по конкретным категориям объектов со степенью уверенности более 99 %. На рис. 19 приводится несколько примеров. Ученые из Вайоминга отметили, что глубокие нейронные сети (ГНС) “считают эти объекты почти идеальными примерами распознаваемых изображений”, а это “[поднимает] вопросы об истинных способностях ГНС к генерализации и потенциальной эксплуатации [то есть вредоносном использовании] дорогостоящих решений на базе ГНС”

[148].

Две эти статьи и последующие связанные открытия не только подняли вопросы, но и посеяли настоящую тревогу среди специалистов по глубокому обучению. Если системы глубокого обучения, которые успешно овладевают компьютерным зрением и выполняют другие задачи, так легко обмануть с помощью манипуляции, не сбивающей с толку людей, разве можно говорить, что эти сети “учатся, как люди”, а их способности “сравнимы с человеческими или превосходят их”? Очевидно, что восприятие нейронных сетей сильно отличается от человеческого. Если эти сети будут применяться в сфере компьютерного зрения в реальном мире, нам лучше убедиться, что они защищены от хакеров, использующих подобные манипуляции, чтобы их обмануть.

Рис. 19. Примеры изображений, созданных генетическим алгоритмом с целью обмануть СНС. В каждом случае AlexNet (обученная на наборе ImageNet) с вероятностью более 99 % относила изображение к одной из представленных на рисунке категорий

Все это подтолкнуло небольшую группу исследователей заняться “состязательным обучением”, то есть разработкой стратегий, защищающих системы машинного обучения от потенциальных противников (людей), которые могут их атаковать. Разработки в области состязательного обучения часто начинаются с демонстрации возможных способов атаки на существующие системы, и некоторые недавние демонстрации поражают воображение. В сфере компьютерного зрения одна группа разработчиков написала программу, которая проектирует оправы очков с особым узором, заставляющим систему распознавания лиц с уверенностью узнавать на фотографии другого человека (рис. 20)

[149]. Другая группа создала небольшие и неприметные наклейки, при помещении которых на дорожные знаки система компьютерного зрения на основе сверточной нейронной сети – вроде тех, что используются в беспилотных автомобилях, – классифицирует знаки неверно (например, знак обязательной остановки распознается как знак ограничения скорости)

[150]. Третья группа продемонстрировала возможную вредоносную атаку на глубокие нейронные сети для анализа медицинских изображений и показала, что рентгеновские снимки и результаты микроскопии можно без труда исказить незаметным для человека образом и тем самым подтолкнуть сеть изменить свою классификацию, скажем, с 99 % уверенности в отсутствии рака на изображении на 99 % уверенности в наличии рака

[151]. Эта группа отметила, что персонал больницы и другие люди потенциально смогут использовать такие микроподлоги для постановки неверных диагнозов, чтобы заставить страховые компании оплачивать дополнительные (и весьма прибыльные) диагностические обследования.